Aktuelles, Experten - geschrieben von dp am Mittwoch, Juli 31, 2024 10:12 - ein Kommentar

EU AI Act ab 1. August 2024 in Kraft: TÜV AI.Lab bietet KI-Compliance-Check an

AI Act als Basis eines globalen Leitmarkts für sichere KI „Made in Europe“

[datensicherheit.de, 31.07.2024] Der TÜV-Verband e.V. geht in seiner aktuellen Stellungnahme auf den mit gestaffelten Übergangsfristen in Kraft tretenden Europäischen „AI Act“ ein – der TÜV-Verband begrüßt demnach diese Regelung und fordert eine rasche Klärung offener Umsetzungsfragen. Das „TÜV AI.Lab“ entwickele zudem ein kostenloses Online-Tool zur Risikoklassifizierung von KI-Systemen und -Modellen – den „AI Act Risk Navigator“.

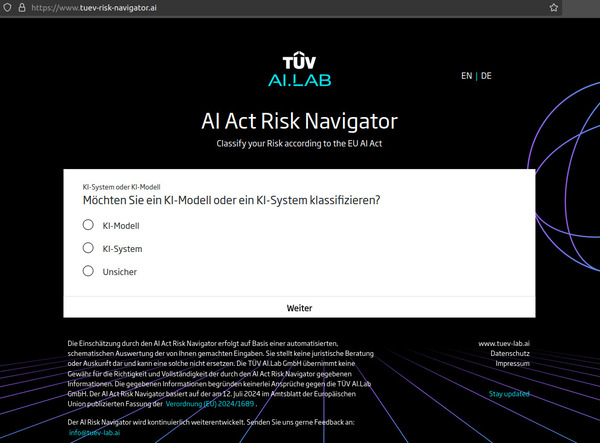

Abbildung: TÜV AI.Lab

AI Act Risk Navigator: „Classify your Risk according to the EU AI Act“

AI Act kodifiziert erstmals Regeln für KI

Der TÜV-Verband unterstützt nach eigenen Angaben das Inkrafttreten des europäischen „AI Act“, womit erstmals Regeln für Künstliche Intelligenz (KI) festlegt würden. Damit werde nun ein global führender Rechtsrahmen für sichere und vertrauenswürdige KI geschaffen.

„Der ,AI Act’ bietet die Chance, vor negativen Auswirkungen von Künstlicher Intelligenz zu schützen und gleichzeitig Innovationen zu fördern. Er kann dazu beitragen, einen globalen Leitmarkt für sichere ‚KI Made in Europe‘ zu etablieren“, kommentiert Dr. Joachim Bühler, Geschäftsführer des TÜV-Verbands.

Dr. Bühler betont: „Es ist jetzt wichtig, die Umsetzung effizient und unbürokratisch zu gestalten. Unabhängige Stellen spielen dabei eine wesentliche Rolle, nicht nur im Hinblick auf die verbindlichen Anforderungen, sondern auch im freiwilligen KI-Prüfmarkt.“

Gestaffelte Übergangsfristen für KI-Systeme bis 2027

Der „EU AI Act“ soll am 1. August 2024 mit gestaffelten Übergangsfristen in Kraft treten. Sechs Monate nach Inkrafttreten, das heißt ab Anfang 2025, sollten zunächst KI-Systeme verboten werden, die unter anderem manipulative oder täuschende Techniken einsetzen.

Ab dem 1. August 2025 werden dann Verhaltenskodizes für bestimmte Allzweck-KI-Modelle in Kraft treten. Zudem müssten die EU-Mitgliedstaaten nationale Behörden für die Marktüberwachung benennen. Verpflichtende Prüfungen für sogenannte Hochrisiko-KI in Bereichen wie Kreditvergabe, Personalwesen oder Strafverfolgung werden ab August 2026 erforderlich sein – und nicht nur KI-Entwickler betreffen, sondern auch KI-Anbieter, und Betreiber risikoreicher KI.

Ab 2027 sollen dann die Anforderungen an KI in „drittprüfpflichtigen Produkten“ in Kraft treten. Dr. Bühler führt hierzu aus: „Prüfungen von KI-Systemen schaffen Vertrauen und sind schon heute ein Wettbewerbsvorteil. Unternehmen sind gut beraten, sich jetzt mit den Anforderungen vertraut zu machen, insbesondere im Hinblick auf die Übergangsfristen. Es ist wichtig, abzuschätzen, wie und wo der ,AI Act’ ihre Aktivitäten betrifft.“

Herausforderungen der Umsetzung: KI-Risiken sowie Entwicklung systemischer Risiken besonders leistungsfähiger Allzweck-KI-Modellen im Blick behalten

„Eine einheitliche Interpretation und konsequente Anwendung des risikobasierten Ansatzes sind entscheidend, damit der ,AI Act’ in der Praxis wirksam wird – hier sind die Mitgliedsstaaten gefordert“, betont Dr. Bühler. Aus Sicht des TÜV-Verbands sollte besonderes Augenmerk auf eine effiziente und unbürokratische Umsetzung gelegt werden.

Klare Zuständigkeiten und „verantwortliche Stellen“ seien notwendig, um die Regelungen praktisch umzusetzen. So sollten Umsetzungsleitfäden für die Einstufung von Hochrisiko-KI-Systemen vom AI Office (Europäisches KI-Büro) schnellstmöglich veröffentlicht werden, um insbesondere kleinen und mittleren Unternehmen (KMU) Rechtssicherheit zu geben.

Darüber hinaus seien neue KI-Risiken sowie die Entwicklung systemischer Risiken von besonders leistungsfähigen Allzweck-KI-Modellen im Blick zu behalten und der Aufbau einer systematischen KI-Schadensberichterstattung voranzutreiben.

TÜV AI.Lab Risk Navigator zeigt soll helfen, Klarheit über Auswirkungen der KI-Verordnung zu schaffen

Das 2023 als Joint Venture der TÜV-Unternehmen gegründete „TÜV AI.Lab“ soll regulatorische Anforderungen an KI in die Prüfpraxis übersetzen und quantifizierbare Konformitätskriterien sowie geeignete Prüfmethoden für KI entwickeln.

Zum Inkrafttreten des „AI Act“ veröffentlicht das „TÜV AI.Lab“ den „AI Act Risk Navigator“ – ein kostenloses Online-Tool zur Risikoklassifizierung von KI-Systemen. „Mit dem ,AI Act Risk Navigator’ des ,TÜV AI.Lab’ bieten wir eine nutzerfreundliche Anwendung, mit der Unternehmen verstehen können, ob und wie sie vom AI Act betroffen sind“, erläutert Franziska Weindauer, Geschäftsführerin des „TÜV AI.Lab“.

„Unser Ziel ist es, Klarheit über die Auswirkungen der KI-Verordnung zu schaffen, so dass Unternehmen sich rechtzeitig vorbereiten können. Wenn wir Qualitätsanforderungen an Künstliche Intelligenz von Beginn an mitdenken, kann vertrauenswürdige Künstliche Intelligenz zum europäischen Alleinstellungsmerkmal werden.“ Der „AI Act Risk Navigator“ soll dabei Unterstützung bieten, KI-Systeme gemäß den Risikoklassen des „AI Act“ einzuordnen und Transparenz über die geltenden Anforderungen zu schaffen.

Anforderungen je nach KI-Risikoklassifizierung

Die EU-Regulierung teile KI-Anwendungen in vier Risikoklassen mit jeweils unterschiedlichen Anforderungen ein, welche in den kommenden Monaten schrittweise einzuhalten seien. Systeme mit hohem Risiko, die in Bereichen wie Medizin, Kritische Infrastrukturen oder Personalmanagement eingesetzt werden, unterlägen beispielsweise künftig strengen Auflagen und müssten umfassende Anforderungen an Transparenz, Sicherheit und Aufsicht erfüllen.

Bei Verstößen drohten Bußgelder von bis zu 15 Millionen Euro oder bis zu drei Prozent des weltweiten Jahresumsatzes. „Wir wissen, dass das für Unternehmen Fragen aufwirft. Deshalb wollen wir zu größerer Klarheit über das eigene Risikoprofil und die zu erfüllenden Anforderungen beitragen“, unterstreicht Weindauer.

Systeme mit begrenztem Risiko, wie etwa sogenannte Chatbots, müssten nur Transparenzanforderungen erfüllen, während Systeme mit minimalem Risiko, wie z.B. einfache Videospiele, gar nicht reguliert würden. Die risikobasierte Klassifizierung solle sicherstellen, „dass der Einsatz von KI sicher und vertrauenswürdig ist, damit so die Innovationskraft der Technologie und deren Marktdurchdringung weiter gesteigert werden kann“.

Weitere Informationen zum Thema:

TÜV AI.LAB

AI Act Risk Navigator / Classify your Risk according to the EU AI Act

ein Kommentar

Kommentieren

Aktuelles, Experten - März 29, 2025 0:44 - noch keine Kommentare

Dringender Branchenappell zum Glasfaser- und Mobilfunkausbau an Digitalministerkonferenz

weitere Beiträge in Experten

- Wahrung der Grundrechte im Fokus: 109. DSK beschließt Forderungen an künftige Bundesregierung

- BGH-Urteil zu Meta-Datenschutzverstoß: Verbraucherzentrale Bundesverband gewinnt Verfahren

- World Backup Day 2025: Regelmäßige Datensicherung laut BSI unverzichtbar

- Koalitionspläne zum Datenschutz: Nachteile für regionale Wirtschaft und Menschen vor Ort befürchtet

- Identify Me: BKA reports further search success

Aktuelles, Branche - März 30, 2025 18:02 - noch keine Kommentare

World Backup Day 2025 als Anlass für Überlegungen zu einer resilienten Datenschutzstrategie

weitere Beiträge in Branche

- ICS/OT Cybersecurity Budget Report 2025: Über 50 Prozent der Befragten fühlen sich bedroht

- Threat to water supply from cyber attacks still underestimated

- Bedrohung der Wasserversorgung durch Cyber-Angriffe noch immer unterschätzt

- Medusa: Ransomware-as-a-Service seit 2021 aktiv – aktuell mit verstärkter Aktivität

- Cyber-Bedrohungen: G DATA warnt vor mangelndem Risikobewusstsein – insbesondere der KMU

Branche, Umfragen - Dez. 21, 2020 21:46 - noch keine Kommentare

Threat Hunting: Bedeutung und Wertschätzung steigt

weitere Beiträge in Service

- Umfrage: 71 Prozent der IT-Entscheidungsträger besorgt über Mehrfachnutzung von Passwörtern

- Fast die Hälfte der Unternehmen ohne geeignete Sicherheitsrichtlinien für Remote-Arbeit

- Umfrage: Bedeutung der Konsolidierung von IT-Sicherheitslösungen

- TeleTrusT-Umfrage: „IT-Sicherheit im Home Office“

- Cybersicherheit: SANS-Studie zu Frauen in Führungspositionen

[…] datensicherheit.de, 31.07.2024 EU AI Act ab 1. August 2024 in Kraft: TÜV AI.Lab bietet KI-Compliance-Check an / AI Act als Basis e… […]